Contenuto

D:

Perché le reti neurali ricorrenti artificiali sono spesso difficili da addestrare?

UN:

La difficoltà di formare reti neurali artificiali ricorrenti ha a che fare con la loro complessità.

Uno dei modi più semplici per spiegare perché le reti neurali ricorrenti sono difficili da addestrare è che non sono reti neurali feedforward.

Nelle reti neurali feedforward, i segnali si muovono solo in una direzione. Il segnale si sposta da un livello di input a vari livelli nascosti e in avanti al livello di output di un sistema.

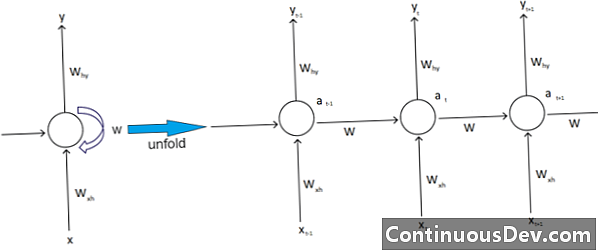

Al contrario, le reti neurali ricorrenti e altri tipi diversi di reti neurali hanno movimenti di segnale più complessi. Classificate come reti di "feedback", le reti neurali ricorrenti possono avere segnali che viaggiano sia in avanti che indietro e possono contenere vari "loop" nella rete in cui numeri o valori vengono reimmessi nella rete. Gli esperti lo associano all'aspetto delle reti neuronali ricorrenti associate alla loro memoria.

Inoltre, esiste un altro tipo di complessità che colpisce le reti neurali ricorrenti. Un eccellente esempio di ciò è nel campo dell'elaborazione del linguaggio naturale.

Nella sofisticata elaborazione del linguaggio naturale, la rete neurale deve essere in grado di ricordare le cose. Deve anche prendere input in con. Supponiamo che esista un programma che vuole analizzare o prevedere una parola all'interno di una frase di altre parole. Ad esempio, il sistema può valutare una lunghezza fissa di cinque parole. Ciò significa che la rete neurale deve avere input per ciascuna di queste parole, insieme alla capacità di "ricordare" o allenarsi sulla truffa di queste parole. Per questi e altri motivi simili, le reti neuronali ricorrenti in genere hanno questi piccoli circuiti nascosti e feedback nel sistema.

Gli esperti lamentano che queste complicazioni rendono difficile la formazione delle reti. Uno dei modi più comuni per spiegarlo è citando il problema del gradiente che esplode e scompare. In sostanza, i pesi della rete porteranno a valori di esplosione o di fuga con un gran numero di passaggi.

Il pioniere della rete neurale Geoff Hinton spiega questo fenomeno sul web affermando che i passaggi lineari all'indietro causeranno la riduzione esponenziale di pesi più piccoli e l'esplosione di pesi più grandi.

Questo problema, continua, peggiora con lunghe sequenze e più numerosi intervalli di tempo, in cui i segnali crescono o decadono. L'inizializzazione del peso può aiutare, ma tali sfide sono integrate nel modello di rete neurale ricorrente. Ci sarà sempre quel problema legato al loro particolare design e alla loro costruzione. In sostanza, alcuni dei tipi più complessi di reti neurali sfidano davvero la nostra capacità di gestirli facilmente. Siamo in grado di creare una quantità praticamente infinita di complessità, ma spesso vediamo crescere le sfide di prevedibilità e scalabilità.