Contenuto

- Definizione - Cosa significa Apache Kudu?

- Un'introduzione a Microsoft Azure e Microsoft Cloud | In questa guida imparerai cos'è il cloud computing e in che modo Microsoft Azure può aiutarti a migrare e gestire la tua azienda dal cloud.

- Techopedia spiega Apache Kudu

Definizione - Cosa significa Apache Kudu?

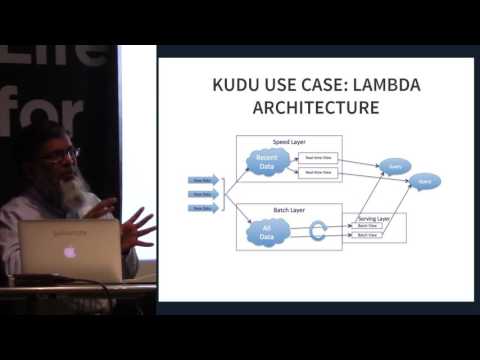

Apache Kudu è un membro dell'ecosistema open source Apache Hadoop. È un motore di archiviazione open source destinato a dati strutturati che supporta l'accesso casuale a bassa latenza insieme a modelli di accesso analitici efficienti. È stato progettato e implementato per colmare il divario tra l'Hadoop Distributed File System (HDFS) ampiamente utilizzato e il database NoSQL HBase. Sebbene questi sistemi possano ancora rivelarsi vantaggiosi, Apache Kudu può soddisfare molti carichi di lavoro comuni poiché può semplificare notevolmente la loro architettura.

Un'introduzione a Microsoft Azure e Microsoft Cloud | In questa guida imparerai cos'è il cloud computing e in che modo Microsoft Azure può aiutarti a migrare e gestire la tua azienda dal cloud.

Techopedia spiega Apache Kudu

Apache Kudu è stato sviluppato principalmente come progetto presso Cloudera. La maggior parte dei contributi finora è stata fornita dagli sviluppatori impiegati da Cloudera. Durante il suo rilascio, solo i file binari di convenienza sono stati inclusi nei repository di Cloudera, tuttavia ha adottato il processo di rilascio del codice sorgente Apache Software Foundation (ASF) al momento dell'adesione all'incubatore. È specificamente progettato per casi d'uso che richiedono analisi rapide su dati veloci. È stato progettato per sfruttare l'hardware di prossima generazione e l'elaborazione in memoria. Riduce significativamente la latenza delle query per Apache Impala e Apache Spark. Distribuisce i dati attraverso il motore di archiviazione colonnare o tramite il partizionamento orizzontale, quindi replica ogni partizione utilizzando il consenso Raft fornendo così un tempo medio di recupero e latenze di coda ridotte.

Sebbene Kudu sia un prodotto progettato nell'ambito dell'ecosistema Apache Hadoop, supporta anche l'integrazione con altri progetti di analisi dei dati sia all'interno che all'esterno dell'ASF.

Apache Kudu si dimostra efficiente in quanto è in grado di elaborare carichi di lavoro analitici in tempo reale su un singolo livello di archiviazione, offrendo così agli architetti la flessibilità di affrontare una più ampia varietà di casi d'uso senza soluzioni esotiche.